Linux笔记关于同步文件

由于insight的数据需要每天同步,所以需要每天定时同步日志到集群的HDFS。所以写了个简单的脚本进行同步。脚本如下 前提是配置好ssh免密码 Shell 01234567891011121314151617181920212223 REMOTE_USER=usernameREMOTE_HOST=example.comREMOTE_SSH_PORT=22REMOTE_LOG_PATH=/edx/var/log/trackingLOCAL_TMP_LOG_PATH=/tmp/insights/bistuHDFS_HOST=hadoop1.example.comHDFS_PORT=9000HDFS_ROOT=hdfs://$HDFS_HOST:$HDFS_PORTHDFS_LOG_PATH=$HDFS ...

Linux服务器基本配置

当拿到一个服务器要开始搭建服务时候,首先应该确认一些设置。。。以免之后被坑。。。 我用的最多的服务器系统版本是Ubuntu 14.04。。以此为例来记录下常见操作 首先确定网络设置,包括IP、DNS、HOSTNAME、HOSTS配置 /etc/resolv.conf中设置dns,常见的202.106.46.151、8.8.8.8、114.114.114.114 持久化DNS配置,/etc/resolvconf/resolv.conf.d/base加入nameserver xxx.xxx.xxx.xxx /etc/network/interfaces中设置IP、网卡等信息、确定能正常上网 /etc/hostname中设置本机名称 /etc/hosts中把localhost和hostname都解析到本地127.0.0. ...

ansible初步–批量升级CDH的jdk

由于要在集群上操作配置、并且即将搭建一个新的集群,所以我不想再像之前一样复制粘贴命令了!!会死人的。。。 so,看了下ansible, 环境:Ubuntu 14.04主机*6 六台服务器运行的命令相同 (前提:已经做完root密钥互信) 安装: sudo apt-get install ansible 配置: sudo /etc/ansible/hosts 添加进去所有主机,并分组,如下 [hadoop] hadoop1.bistu.edu.cn hadoop2.bistu.edu.cn hadoop3.bistu.edu.cn hadoop4.bistu.edu.cn hadoop5.bistu.edu.cn hadoop6.bistu.edu.cn 批量传送文件,这次是升级jdk 把安装包放到所有主机的home下 an ...

CDH5分布式运行任务的各种坑(更新ing)

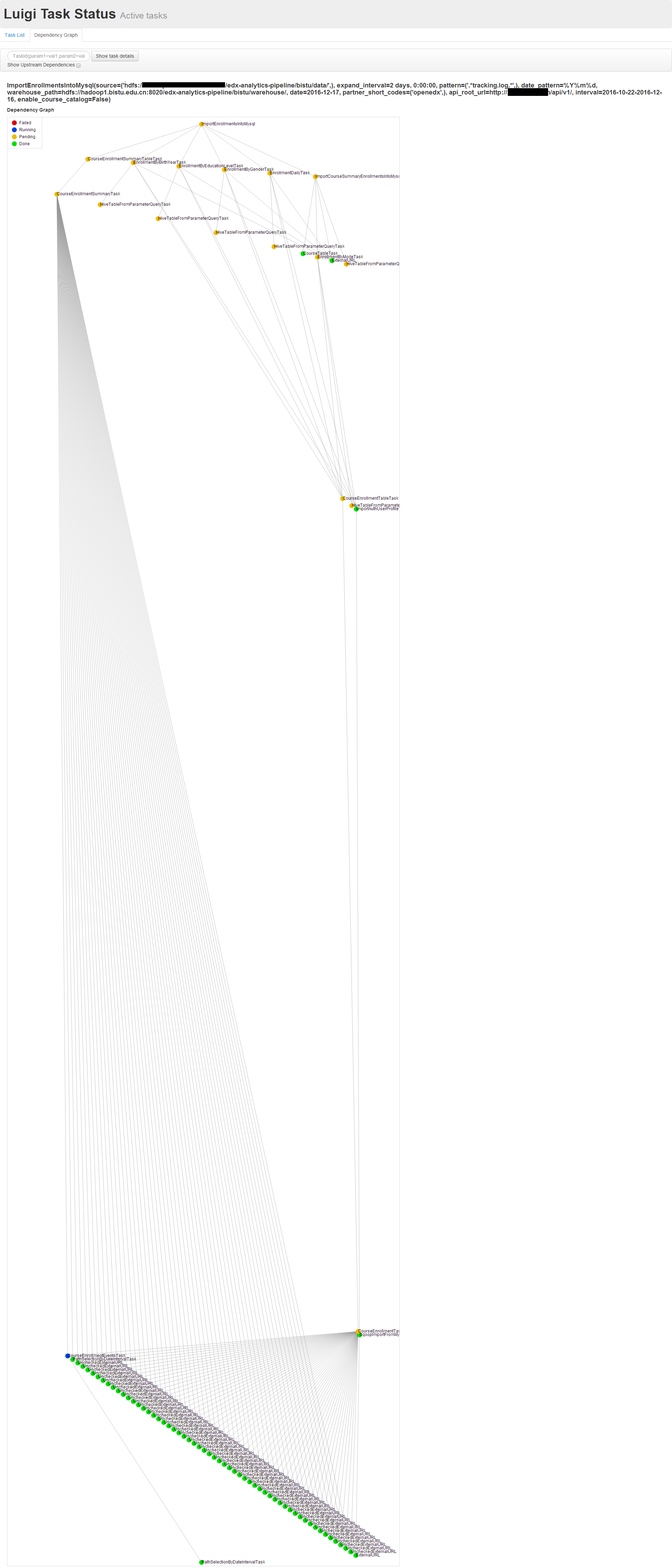

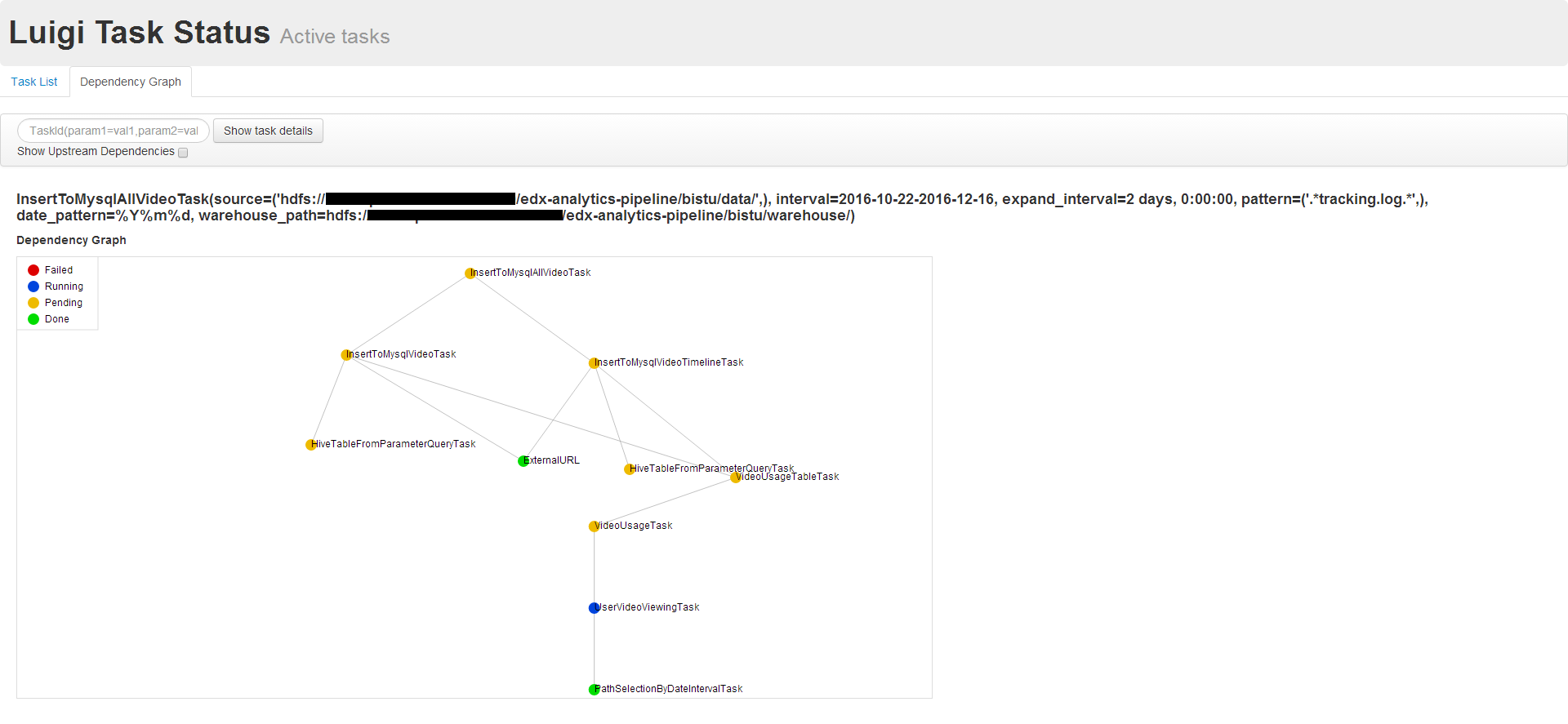

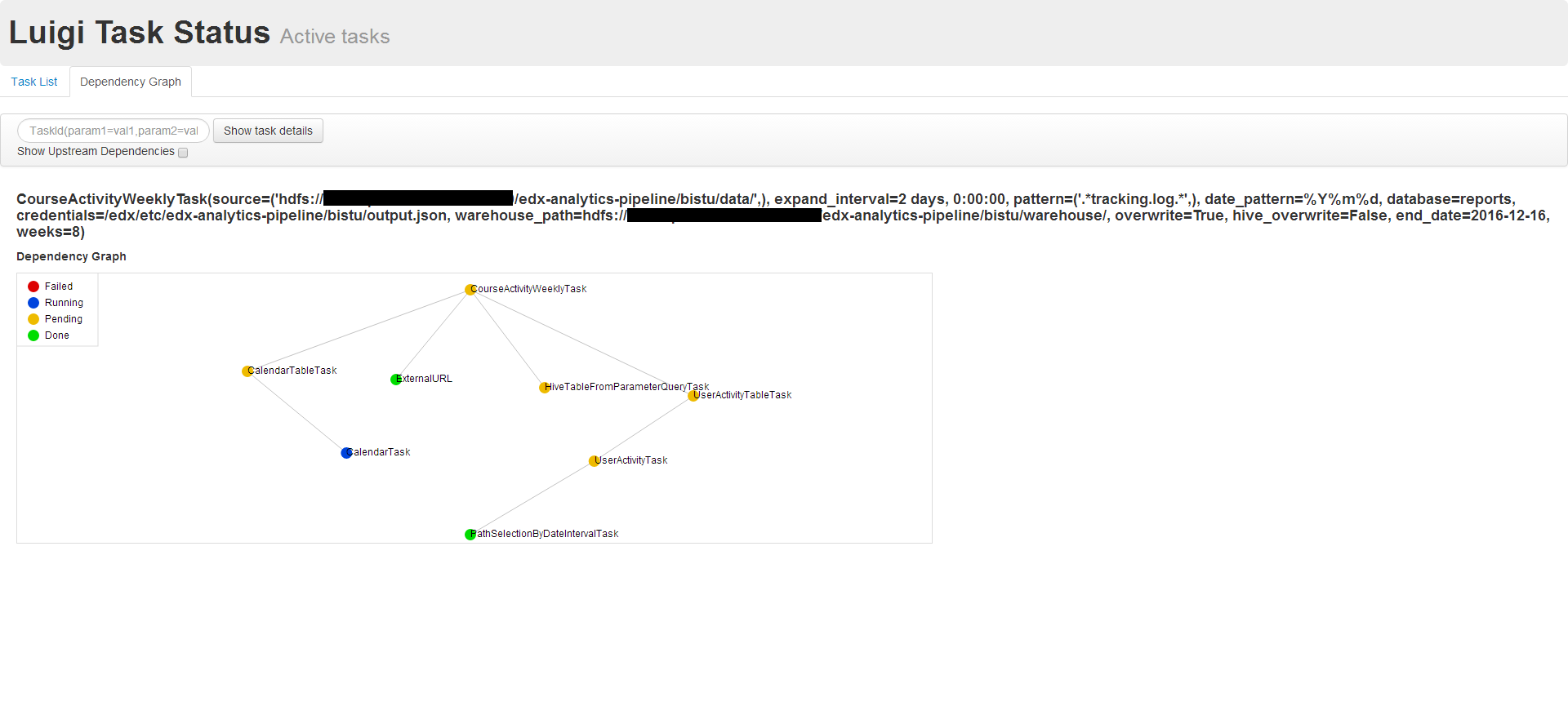

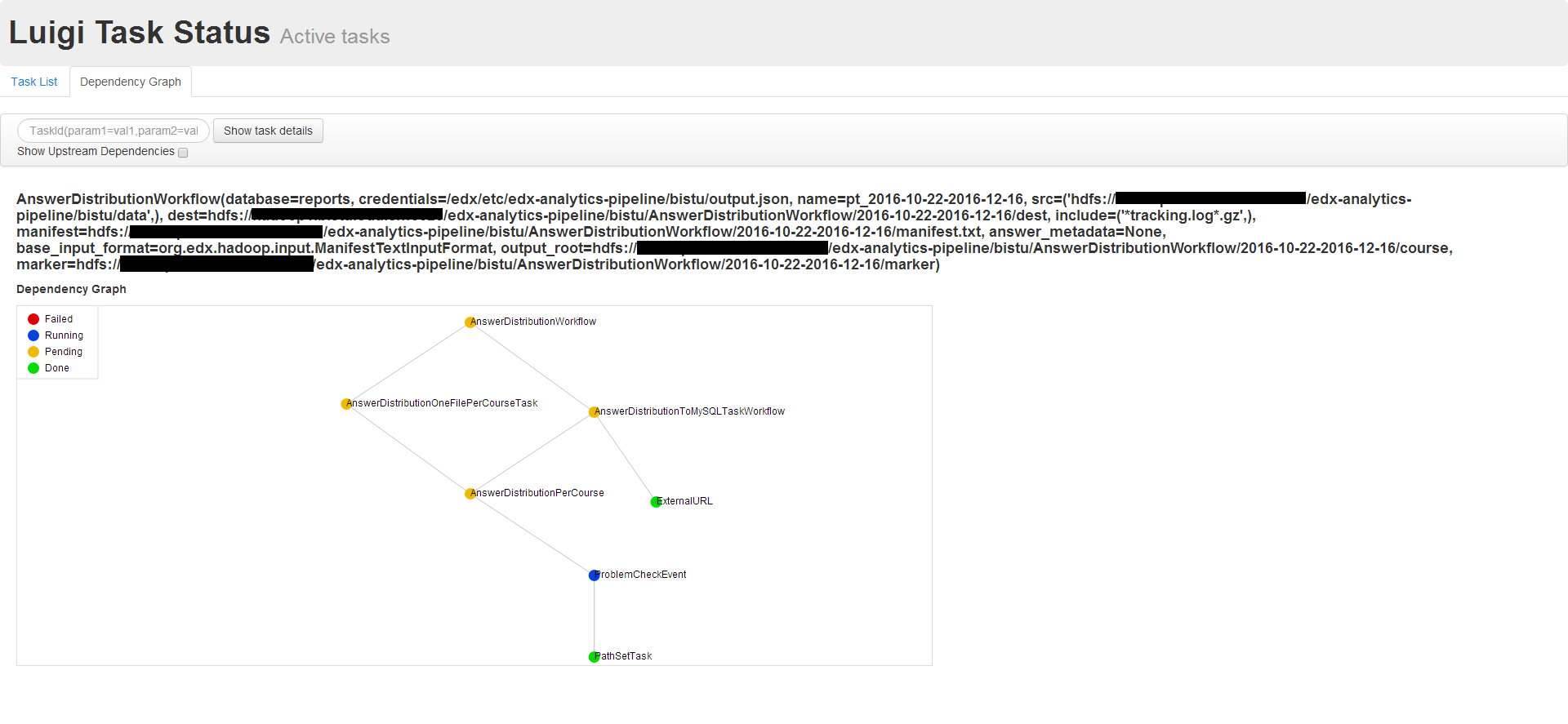

# CDH搭建、配置(待填坑) # 角色分配设计(待填坑) # 参数调优(待填坑) 因为要把edX中Insight的数据导入到一个6节点集群中做运算,所以尝试分离pipline,远程执行分析任务。具体过程有时间另写文章分析(先挖个坑)=-= 今天发现luigi调度任务的时候把任务挂起后就不动了,最开始怀疑luigi配置问题,按官方文档修改metastore_host和metastore_port均无效 但是CDH的监控显示hive的Server正常运行,查看日志也没看到输出错误,然后我查看了task的源码发现需要从hive中查询数据,所以怀疑hive配置有问题, hive配置文件由/etc/hive/conf指 ...

IIS访问无扩展名图片404的解决

由于图片没扩展名,所以IIS会认为没这个目录。

解决方案:

打开IIS管理器,选中网站,点开MIME类型。

添加一个新的类型

文件扩展名写.(这是一个英文的点)

MIME类型写application/octet-stream

问题解决

CAS对接Open edX

Open edX的第三方登录是作为一个django app存在的,配置过程如下。 LMS配置过程 ##安装CAS的Client、Mapper 进入edXapp环境,下载CAS的Client、Mapper C 0123456 sudo su edxapp -s /bin/bashcd ~source edxapp_envpip install git+https://github.com/kstateome/django-caspip install git+https://github.com/eduStack/neusoft_cas_mapper CAS Client安装目录在下面的地址 C ...